Umělá inteligence (AI) se s tichou samozřejmostí stala součástí životů mnohých z nás. Pomáhá nám psát, programovat, tvořit obrazy a plánovat dovolenou. Její schopnosti působí téměř magicky, jako by se rodily někde mimo realitu. Rodí se však v serverovnách konzumujících obrovské množství energie.

Za každou odpovědí chatbota, za každým vygenerovaným obrázkem stojí nesmírně komplexní a energeticky hladová fyzická infrastruktura. Právě zde, v řadách hučících serverů ukrytých v datových centrech po celém světě, se rodí dvě klíčové otázky naší doby.

Za každou odpovědí chatbota, za každým vygenerovaným obrázkem stojí nesmírně komplexní a energeticky hladová fyzická infrastruktura. Právě zde, v řadách hučících serverů ukrytých v datových centrech po celém světě, se rodí dvě klíčové otázky naší doby.

První je konkrétní a osobní: Kolik energie vlastně stojí jeden můj dotaz, jedno mé kliknutí?

Druhá má mnohem širší a hlubší dopady: Jaký je celkový energetický apetit celého odvětví umělé inteligence a jak jeho dramatický růst promění nejen naše účty za elektřinu, ale i celou energetickou soustavu?

Na začátek dovolte malé vysvětlení. Při hledání odpovědí se náš pohled nevyhnutelně stáčí za Atlantický oceán. Spojené státy jsou dnes epicentrem vývoje AI. Působí zde všechny klíčové firmy od OpenAI a Googlu přes Metu a Microsoft až po výrobce nepostradatelných čipů, společnost Nvidia. Právě USA se tak staly obří laboratoří, kde se budoucnost umělé inteligence zhmotňuje nejrychleji. Díky tomu, že jde o jeden státní celek s relativně uceleným trhem, máme odtud k dispozici nejlepší dostupná data. Americký vývoj tak slouží jako nejvěrnější model pro pochopení globálních trendů, které dříve či později v plné síle dorazí i do Evropy.

Tempo růstu a objem investic do AI nemají v nedávné historii technologií obdoby. Nejde o pouhé pokračování digitalizace, na kterou jsme zvyklí. Pro srovnání: mezi lety 2005 a 2017 zůstávala celková spotřeba datových center ve Spojených státech díky neustálému zvyšování efektivity pozoruhodně stabilní, i přes rychlý nárůst jejich výpočetní kapacity.

Po roce 2017 však nástup AI vše změnil a spotřebu do roku 2023 zdvojnásobil. Iniciativy jako projekt Stargate, za nímž stojí OpenAI a Microsoft a jehož cílem je vybudovat datová centra s ohromující spotřebou, nebo masivní investice Googlu a Mety do vlastní AI infrastruktury jsou toho jasným důkazem. Podle analýzy z roku 2024 dnes datová centra v USA spotřebovávají přibližně 4,4 % veškeré elektřiny vyrobené v zemi. A to je teprve začátek.

S tím, jak se umělá inteligence stává personalizovanější, schopnější řešit komplexní problémy a všudypřítomnou součástí našich aplikací, její „hlad po energii“ poroste. Tuto tezi silně podporuje i nová projekce prestižní Lawrence Berkeley National Laboratory, financované americkým ministerstvem energetiky. Podle jejích odhadů bude již do roku 2028 více než polovina veškeré elektřiny směřující do datových center využívána právě pro účely AI. V takovém scénáři by samotná umělá inteligence mohla ročně spotřebovat tolik elektřiny jako 22 % všech amerických domácností dohromady.

Anatomie spotřeby

Abychom pochopili, kde se tato obrovská spotřeba bere, musíme rozlišovat dvě základní fáze života každého AI modelu. Tou první je trénink. Jde o jednorázový, časově i finančně extrémně náročný proces, během kterého se model učí z obrovského množství dat. Například trénink slavného modelu GPT-4 od OpenAI stál podle odhadů více než 100 mil. USD a spotřeboval přes 50 GWh energie.

Jakmile je pak „výcvik“ u konce, přichází fáze každodenního provozu. Ten se v jazyce AI nazývá „inference“ a představuje veškeré používání modelu — zodpovídání dotazů, generování textů, obrázků či kódu. A právě zde, v každodenním provozu, se skrývá hlavní, neustále rostoucí energetický náklad. Odhady expertů říkají, že inference dnes tvoří 80 až 90 % veškeré výpočetní síly a energie spotřebované v odvětví umělé inteligence. Teprve ve fázi inference začíná model vydělávat peníze a splácet ohromné počáteční náklady na svůj trénink. Pro planetu to znamená, že skutečný účet za AI platíme s každým dalším dotazem.

Celý proces probíhá, IT žargonem řečeno, v „cloudu“, ale za tímto výrazem stojí fyzická infrastruktura, tedy datová centra. Jde o strojovny moderního digitálního světa naplněné tisíci hučících serverových skříní. Svaly operací AI tvoří specializované čipy zvané grafické procesory neboli GPU.

Lídrem trhu je v tomto jednoznačně Nvidia se svými GPU, např. s velmi rozšířeným modelem H100. Tyto čipy jsou navrženy tak, aby zvládaly masivní paralelní výpočty, které AI vyžaduje, jejich výkon je však vykoupen značnou spotřebou energie a produkcí velkého množství tepla.

Samotné GPU však nejsou jediným spotřebičem. Energii vyžadují i centrální procesory (CPU), které jim „servírují“ data, a především gigantické chladicí systémy bránící přehřátí celé infrastruktury — k tomu je zapotřebí pochopitelně vhodný zdroj vody. Připočíst musíme rovněž nevyhnutelné ztráty energie v rozvodech a provoz dalších pomocných technologií.

Snaha zjistit, kolik přesně stojí jeden dotaz, naráží na hradbu mlčení největších hráčů. Komerční modely jako ChatGPT, Gemini od Googlu nebo Claude od Anthropic fungují jako takzvané „černé skříňky“. Jejich tvůrci si detaily o architektuře a spotřebě pečlivě střeží. Považují je za cenné obchodní tajemství a pravděpodobně se také obávají negativní publicity, kterou by konkrétní čísla mohla vyvolat. Jak tedy můžeme energetický apetit AI vůbec měřit?

Logickou cestou je hledat odpověď v open-source modelech, jako je například Llama od společnosti Meta. Ty si mohou výzkumníci volně stáhnout, provozovat na vlastním hardwaru a pomocí specializovaných nástrojů, jaké vyvíjí např. iniciativa Hugging Face, měřit jejich reálnou spotřebu GPU.

Jak ale odhadnout spotřebu celého systému včetně chlazení a dalších komponent? Praktické pravidlo nabídla studie expertů z Microsoftu z roku 2024: pro hrubý, ale použitelný odhad celkové spotřeby stačí zdvojnásobit naměřenou spotřebu samotného grafického procesoru. Kolik stojí odpověď Díky práci výzkumníků, kteří zkoumají otevřené modely, můžeme konečně nahlédnout do strojovny AI a pokusit se změřit cenu jednotlivých úkonů. Začněme u nejběžnějšího použití: generování textu. Analýza modelů Llama od Mety, kterou provedli experti z Michiganské univerzity, ukazuje obrovské rozdíly.

Malý a efektivní model (Llama 3.1 8B) si na vygenerování jedné průměrné odpovědi vezme zhruba 110 J energie. To je množství, které by stačilo na ujetí pouhých 2 m na elektrokole. Jeho mnohem větší a schopnější kolega (Llama 3.1 405B) je však řádově náročnější. Jedna odpověď u něj vyjde na přibližně 6 700 J — to představuje pár sekund provozu mikrovlnné trouby.

Spotřebu ovlivňuje nejen velikost modelu, jejíž nejvyšší verze, jako je GPT-4 od OpenAI, mají podle odhadů přes bilion parametrů. Záleží i na složitosti úkolu. Žádost o pár vtipů může spotřebovat až 9× méně energie než zadání na napsání komplexního, kreativního příběhu.

Jinak je tomu u generování obrázků. Zde pracují takzvané difuzní modely, jejichž energetická náročnost je překvapivě konzistentní. Nezáleží na tom, zda si přejete obrázek slona v obýváku, nebo astronauta pěstujícího zeleninu na Marsu — spotřeba bude prakticky stejná. Rozhoduje velikost modelu, požadované rozlišení a počet takzvaných difuzních kroků, které určují výslednou kvalitu obrazu.

Vygenerování obrázku ve standardní kvalitě pomocí jednoho z předních open-source modelů Stable Diffusion 3 vyžaduje podle odborníků cca 2 300 J. Pokud byste chtěli kvalitu zdvojnásobením počtu kroků vylepšit, spotřeba se téměř zdvojnásobí na zhruba 4 400 J. To je stále o něco méně, než kolik si vezme velký textový model za jedinou složitější odpověď.

Skutečný energetický skok však přichází s videem. Příkladem může být open-source model CogVideoX. Jeho starší, jednodušší verze dokázala vytvořit jen zrnitou, 8 snímků/s rychlou animaci, která připomínala spíše formát GIF. Ta si vzala přibližně 109 000 J.

Jen o tři měsíce později však tvůrci představili novější, podstatně kvalitnější model zvládající 5s video se 16 snímky/s. Tento skok v kvalitě byl ovšem vykoupen více než 30násobným nárůstem spotřeby. Jediné 5minutové video si vyžádá ohromujících 3,4 mil. J. Pro představu, to je srovnatelné se spotřebou běžné mikrovlnné trouby o příkonu 1 000 W, kterou byste nechali běžet téměř hodinu. Je to také více než 700× více energie, než kolik je potřeba na vytvoření jednoho kvalitního obrázku. Komerční modely jako Sora od OpenAI jsou přitom ještě podstatně kvalitnější a jejich energetická náročnost bude pravděpodobně ještě vyšší.

Pojďme si tyto dílčí údaje spojit do jednoho modelového dne. Představte si, že organizujete charitativní sbírku a pomocí AI si chcete usnadnit práci. Položíte textovému modelu 15 dotazů, jak nejlépe postupovat. Poté 10× zkusíte vygenerovat ideální obrázek pro váš leták, než budete spokojeni. Nakonec si necháte 3× vytvořit 5s video pro sociální sítě. Celková spotřeba za tuto aktivitu by se vyšplhala na přibližně 2,9 kWh. To je dost na nějakých 10 km jízdy elektromobilem (u některých modelů i 20 km) či na provoz mikrovlnné trouby po dobu delší než 3,5 hodiny.

Zde je však na místě jedno zásadní varování. Tato čísla, založená na měření otevřených modelů, nelze v žádném případě považovat za přesný údaj o spotřebě komerčních služeb jako ChatGPT.

Jak řekla pro časopis MIT Technology Review výzkumnice Sasha Luccioniová z Hugging Face, která se energetickou náročností AI dlouhodobě zabývá: „Měli bychom přestat s pokusy o zpětné dopočítávání čísel na základě dohadů a místo toho vyvíjet větší tlak na společnosti, aby konečně sdílely ta skutečná.“xxxxxxxxxxxxjí globální data? Pohled Mezinárodní energetické agentury

| Co říkají globální data? Pohled Mezinárodní energetické agentury |

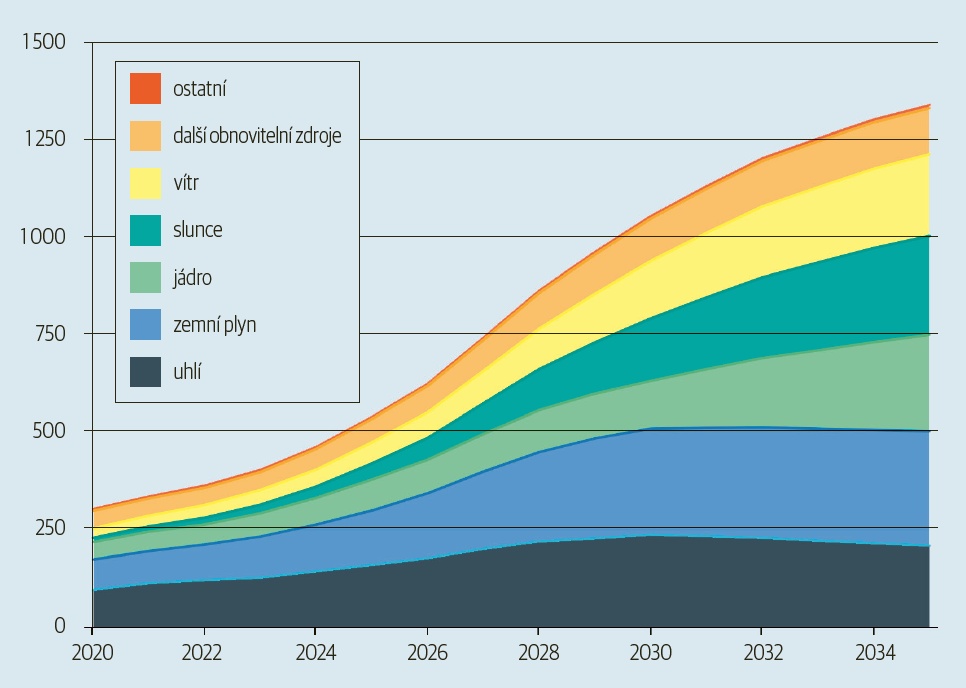

Zatímco se v hlavním textu noříme do detailů spotřeby jednotlivých modelů, pohled z ptačí perspektivy nabízí Mezinárodní energetická agentura (IEA). Její analýzy představují nejautoritativnější globální odhad toho, jak energetický apetit datových center a umělé inteligence promění světovou energetickou mapu. Ačkoliv agentura zdůrazňuje, že budoucnost je zatížena značnou nejistotou, její základní scénář kreslí jasný obrázek rapidního růstu. Zatímco se v hlavním textu noříme do detailů spotřeby jednotlivých modelů, pohled z ptačí perspektivy nabízí Mezinárodní energetická agentura (IEA). Její analýzy představují nejautoritativnější globální odhad toho, jak energetický apetit datových center a umělé inteligence promění světovou energetickou mapu. Ačkoliv agentura zdůrazňuje, že budoucnost je zatížena značnou nejistotou, její základní scénář kreslí jasný obrázek rapidního růstu. V roce 2024 činí odhadovaná spotřeba všech datových center na světě přibližně 415 TWh, což odpovídá zhruba 1,5 % celosvětové spotřeby elektřiny. Hlavním motorem budoucího růstu je přitom jednoznačně AI, která si žádá nasazení energeticky náročných specializovaných serverů. Zatímco spotřeba konvenčních serverů poroste o 9 % ročně, u serverů pro AI se v základním scénáři IEA očekává roční růst o ohromujících 30 %. Projekce agentury ukazují, že do roku 2030 se celosvětová spotřeba elektřiny v datových centrech více než zdvojnásobí a dosáhne přibližně 945 TWh. Jejich podíl na globální spotřebě tak vzroste na necelá 3 %. Ačkoliv se to může zdát jako malý podíl, tempo růstu je mimořádné — odhadovaných 15 % ročně je více než 4× rychlejší než růst všech ostatních sektorů dohromady. Geograficky se růst soustředí především do USA a Číny, které se na něm budou podílet téměř 80 %. Mimořádně ilustrativní je pohled na spotřebu na obyvatele. V USA se očekává nárůst z 540 kWh na osobu v roce 2024 na více než 1 200 kWh v roce 2030, což je řádově více než v jakémkoliv jiném regionu světa. Jak bude tato obrovská poptávka pokryta? Podle IEA sehrají klíčovou roli obnovitelné zdroje, které by měly pokrýt téměř polovinu nově vzniklé poptávky do roku 2030. Jejich růst však nebude stačit. Zemní plyn a uhlí tak budou muset do roku 2030 uspokojit přes 40 % dodatečné spotřeby. Po roce 2030 by se měla stále významněji zapojovat jaderná energetika, mimo jiné i díky malým modulárním reaktorům (SMR), do jejichž vývoje technologické firmy samy investují. Díky tomuto mixu IEA předpokládá, že emise CO2 z provozu datových center dosáhnou vrcholu kolem roku 2030 (cca 320 mil. t) a poté začnou mírně klesat. Agentura nicméně zdůrazňuje, že jde o základní odhad. Připravila proto i alternativní scénáře. V případě rychlé adopce AI by spotřeba mohla do roku 2035 přesáhnout 1 700 TWh. Naopak ve scénáři založeném na výrazném pokroku v efektivitě hardwaru i softwaru by bylo možné stejné digitální služby poskytovat se spotřebou jen okolo 970 TWh. Budoucnost tak bude záviset na tempu inovací a rychlosti adaptace nových technologií. |

Emisní účet

Zajímavou a velmi diskutovanou otázku je emisní stopa umělé inteligence — a ta záleží na tom, jaká energie se pro ni použije. Klíčovým měřítkem je takzvaná „uhlíková intenzita“, která udává, kolik gramů ekvivalentu CO2 se uvolní do atmosféry při výrobě 1 kWh elektřiny.

Podle preprintové studie týmu z Harvardovy univerzity je elektřina spotřebovaná datovými centry v USA v průměru o 48 % uhlíkově intenzivnější než průměr americké sítě. Důvodem je jejich důraz na předvídatelnost: potřebují nepřetržitý, stabilní příkon 24 hodin denně, 7 dní v týdnu.

To omezuje využití obnovitelných zdrojů, jako jsou solární a větrné elektrárny, a naopak nahrává fosilním palivům. U amerických datových center se tato hodnota podle studie pohybuje mezi 400 a 700 g podle oblasti. Průměrná hodnota uhlíková intenzity české energetiky pro rok 2024 byla okolo 430 g ekvivalentu CO2/kWh.

Na místě a čase tedy skutečně záleží. Vraťme se k našemu příkladu s charitativní sbírkou a spotřebou 2,9 kWh. Pokud by tuto energii dodala relativně čistá kalifornská síť, vyprodukovalo by se v průměru asi 650 g emisí CO2. Pokud by se však o napájení postarala síť v Západní Virginii, která je silně závislá na uhlí, emise by přesáhly 1 150 g. Rozdíly jsou patrné i v průběhu jediného dne. V Kalifornii může intenzita během slunečného odpoledne klesnout pod 70 g, ale v noci, kdy solární panely nevyrábějí, vyskočí i o více než 300 g nad průměr. Stejný dotaz tak může mít v závislosti na okolnostech i několikanásobně odlišný dopad na klima.

Společnosti jako Meta, Amazon a Google proto ohlásily plány na masivní investice do jaderné energetiky, která jako jediná nabízí stabilní a zároveň bezemisní zdroj energie. Jde však o plány s horizontem realizace v řádu let, ne-li dekád. Okamžitá a překotná poptávka po energii pro nová datová centra si však žádá rychlá řešení a ta často nejsou ani čistá, ani elegantní.

V dubnu 2024 odhalily satelitní snímky, že superpočítačové centrum společnosti X Elona Muska nedaleko Memphisu využívá desítky generátorů na zemní plyn, aby doplnilo dodávky ze sítě. Takové zkratky jsou v současném závodě o dominanci v oblasti AI běžnou praxí a ukazují na napětí mezi deklaracemi o „klimatické odpovědnosti“ a potřebou pracovat na AI hned.

Kam to míří?

Dílčí čísla o spotřebě jednotlivých dotazů jsou sice zajímavá, ale teprve jejich zasazení do širšího kontextu odhalí skutečný rozměr celého fenoménu. Podívejme se na jeden jediný, byť dominantní nástroj: ChatGPT.

Podle odhadů je dnes 5. nejvyužívanější webovou stránkou na světě, hned za Instagramem. V prosinci 2023 firma OpenAI uvedla, že její chatbot denně zpracuje miliardu dotazů. Pokud bychom pro hrubý odhad použili čísla z výzkumu firmy Epoch AI a výše uvedené propočty pro generování obrázků, jen tato jediná služba by za rok spotřebovala přes 140 GWh elektřiny. A to se bavíme pouze o jedné firmě a jejích veřejně známých produktech, nikoliv o celém ekosystému startupů, výzkumných institucí a dalších technologických gigantů.

Bylo by ovšem chybou předpokládat, že budoucnost bude pouhou extrapolací současnosti. To, jak používáme AI dnes, je jen nepatrnou ochutnávkou toho, co se na nás chystá. Vývoj směřuje od jednoduchého kladení otázek k mnohem komplexnějším a energeticky náročnějším aplikacím.

Brzy se dočkáme AI agentů, kteří budou autonomně plnit úkoly za nás, aniž bychom museli dohlížet na každý jejich krok. Už dnes existují modely schopné takzvaného „hlubokého uvažování“, které si pro vyřešení problému samy generují mnohastránkové logické řetězce a jejichž spotřeba je zřejmě výrazně vyšší — u některých modelů zhruba 40×.

Budoucnost patří personalizovaným modelům, neustále trénovaným na našich datech, a také hlasovým a video asistentům, kteří budou v našich zařízeních aktivní nepřetržitě. Budoucnost AI není pasivní čekání na dotaz, ale neustálá, proaktivní činnost.

Co to znamená v řeči čísel, nejlépe ilustruje již zmíněná klíčová zpráva z Lawrence Berkeley National Laboratory. Její autoři na základě veřejných i neveřejných dat dospěli k jasným závěrům. V roce 2024 spotřebovala všechna datová centra v USA přibližně 200 TWh elektřiny. Z toho specificky na provoz AI serverů připadlo podle odhadů 53—76 TWh.

Pro srovnání: to je už dnes více než celá roční spotřeba ČR, která v roce 2023 činila necelých 60 TWh.

Predikce do budoucna je ještě výraznější. V roce 2028 by se měla spotřeba jen na AI v USA vyšplhat na 165 až 326 TWh ročně, tedy na zhruba trojnásobek až téměř šestinásobek současné roční spotřeby celé české ekonomiky — všech domácností, podniků i dopravy dohromady.

Ono se to vyřeší (v dobrém i zlém)

Jde tedy doslova o velký problém, proto na něj samotní tvůrci AI (a hlavně majitelé příslušných firem) neradi upozorňují. Redakce MIT Technology Review požádali společnosti Google, OpenAI a Microsoft o konkrétní údaje ke spotřebě jejich modelů. Výsledkem byla zdvořilá odmítnutí, obecná prohlášení o snaze o udržitelnost a poukazy na dílčí zlepšení efektivity.

Právě tento postoj ostře kritizují i autoři zprávy z Lawrence Berkeley Lab. Podle nich nedostatek transparentnosti ze strany technologických firem, provozovatelů datových center i výrobců hardwaru znemožňuje vytvořit rozumné projekce a efektivně plánovat rozvoj energetické sítě. Růst datových center tak probíhá „s malým ohledem na to, jak nejlépe integrovat tuto nově vznikající zátěž s rozšiřováním výroby a přenosu elektřiny nebo se širším rozvojem komunit“.

Tento problém s nedostatkem detailních dat se přitom netýká jen Spojených států. Také v Česku a v celé Evropě se spotřeba datových center obvykle schová do obecné statistické kategorie průmyslu. Detailní studie, které by modelovaly budoucí dopady rozvoje AI na stabilitu a kapacitu české přenosové soustavy, tedy prozatím chybějí. Plánování naší energetické budoucnosti tak probíhá bez znalosti jedné z klíčových proměnných.

Kromě zátěže pro energetickou síť se objevuje i další, často přehlížený aspekt: kdo tento energetický boom nakonec zaplatí? Výzkum provedený v rámci iniciativy Electricity Law na Harvardově univerzitě analyzoval dohody mezi energetickými společnostmi a technologickými giganty. Zjistil, že masivní slevy na ceně elektřiny, které si datová centra často vyjednají, mohou vést ke zvýšení cen pro ostatní — tedy pro běžné domácnosti a firmy.

Konkrétní příklad nabízí zpráva zákonodárného sboru státu Virginie z roku 2024. Ta odhaduje, že kvůli nákladům na posílení sítě pro datová centra by průměrná domácnost v tomto státě mohla v budoucnu platit měsíčně navíc až 37,50 USD.

Tento model pochopitelně nelze automaticky přenášet do českého prostředí, které má odlišnou strukturu a regulaci trhu. Jde však o varovný příklad potenciálního důsledku, který ukazuje, že účet za umělou inteligenci může přistát na stole těch, kdo z ní bezprostředně žádný užitek mít nemusí.

Výzva pro rodící se odvětví

Při pohledu na energetickou stopu AI se nám odhaluje zjevný paradox. Cena za jeden konkrétní dotaz se může zdát triviální, srovnatelná s několika sekundami chodu kuchyňského spotřebiče. Součet miliard těchto operací denně, kombinovaný s nástupem řádově náročnějších aplikací, však vytváří značný tlak na globální energetické zdroje. Takzvaná „umělá inteligence“ tedy aktivně přetváří fyzickou infrastrukturu našeho světa.

Je velmi pravděpodobné, že se nacházíme v okamžiku vzniku nového odvětví. Je proto naprosto přirozené, že mnoho otázek zůstává nezodpovězených a přesné dlouhodobé předpovědi jsou obtížné. Dnešní nejistota není známkou krize, ale přirozeným stavem věcí v překotně se vyvíjejícím oboru.

O to důležitější je však způsob, jakým k této nejistotě přistoupíme. Přesnější a veřejně dostupná data o spotřebě nejsou samoúčelná. Jsou podkladem pro zodpovědné plánování energetických sítí, pro cílené inovace v oblasti hardwarové i softwarové efektivity, a především pro informovanou veřejnou debatu.

| Proč GPU |

GPU (graphics processing unit) je celkem běžnou součástí počítačů, telefonů a dalších zařízení už několik desetiletí. Jde o specializovaný mikroprocesor zajišťující rychlé grafické výpočty a změny obsahu videopaměti, které jsou posléze zobrazovány na displeji. Grafický procesor se vůči hlavnímu procesoru (centrálních procesorovou jednotkou — CPU) počítače chová jako další paralelní koprocesor. GPU (graphics processing unit) je celkem běžnou součástí počítačů, telefonů a dalších zařízení už několik desetiletí. Jde o specializovaný mikroprocesor zajišťující rychlé grafické výpočty a změny obsahu videopaměti, které jsou posléze zobrazovány na displeji. Grafický procesor se vůči hlavnímu procesoru (centrálních procesorovou jednotkou — CPU) počítače chová jako další paralelní koprocesor. GPU jsou neodmyslitelnou součástí výkonných grafických karet (ovšem mohou být také osazeny přímo na základních deskách počítačů nebo integrovány v mikroprocesoru spolu s CPU jako tzv. APU — accelerated processing unit) vytvářejících 3D realistická prostředí her a podporující náročné výpočty grafických či animačních programů už před nástupem AI, a v tomto segmentu Nvidia už dlouho dominovala. GPU byly a jsou jakousi podporou CPU. Teprve později se ukázalo, že jsou moderní GPU díky svým schopnostem paralelních výpočtů skvěle využitelné i k jiným účelům, než je zobrazování dat, typicky např. pro těžbu kryptoměn nebo učení neuronových sítí, které jsou i základem AI. A Nvidia si díky včasným reakcím na tyto nové poptávky trhu svůj náskok před konkurencí nejen udržela, ale ještě ho navýšila. Z IT pohledu je role CPU vlastně pořád stejná, tvoří základ všech počítačů, serverů, tabletů i mobilních telefonů, GPU jej však svou významně rostoucí rolí s nástupem AI začínají poněkud zastiňovat. -mim |